L’articolo esplora la complessa relazione tra etica e intelligenza artificiale, analizzando le sfide e le considerazioni legate a bias algoritmici, privacy, responsabilità delle decisioni automatizzate e altro ancora. Vengono discusse anche le potenziali soluzioni, come la creazione di IA spiegabile e l’importanza di standard etici per guidare lo sviluppo delle tecnologie AI.

Bias algoritmici: come mitigarne gli effetti

I bias algoritmici rappresentano una delle sfide più rilevanti nel campo dell’intelligenza artificiale.

Questi bias possono generare discriminazioni involontarie perché spesso i dati utilizzati per addestrare gli algoritmi riflettono bias preesistenti nella società.

Per affrontare questo problema, è essenziale implementare pratiche di data governance che promuovano la diversità e l’inclusione nei set di dati.

La trasparenza nei processi di apprendimento è cruciale per identificare e correggere le distorsioni.

Inoltre, i team di sviluppo devono essere composti da individui con background differenti per portare nuove prospettive al design degli algoritmi.

L’adozione di strumenti di analisi e monitoraggio continua può aiutare a rilevare i bias emergenti durante le fasi di test e utilizzo dei sistemi.

Collaborare con esperti di etica e rappresentanti di minoranze può facilitare la comprensione degli impatti negativi di questi algoritmi, garantendo che la tecnologia serva equamente tutti i gruppi sociali.

AI e privacy: proteggere i dati personali

La protezione della privacy dei dati personali è una preoccupazione crescente mentre le tecnologie AI diventano sempre più pervasive.

Le normative come il GDPR in Europa sono state progettate per tutelare i diritti degli individui, imponendo alle aziende l’obbligo di salvaguardare i dati personali.

Implementare misure di anonimizzazione e aggregazione dei dati può ridurre il rischio di esposizione di informazioni sensibili.

È fondamentale che le organizzazioni adottino pratiche di data minimization, raccogliendo solo i dati strettamente necessari.

Le tecniche di crittografia avanzate possono proteggere i dati in transito e a riposo, mentre la formazione continua del personale in tema di privacy e sicurezza dei dati contribuisce a ridurre il rischio di violazioni.

Le aziende devono anche essere trasparenti sulle modalità di utilizzo dei dati e permettere agli individui di esercitare i propri diritti in modo semplice e accessibile, inclusa la possibilità di richiedere la cancellazione dei propri dati.

Responsabilità delle decisioni automatizzate

Con l’aumento della dipendenza dalle decisioni automatizzate, sorge la questione della responsabilità.

Chi è responsabile degli errori commessi dai sistemi di intelligenza artificiale? Le organizzazioni devono chiarire la catena di responsabilità e assicurarsi che esistano meccanismi per contestare le decisioni errate.

Questo include la possibilità per gli utenti di richiedere una revisione umana delle decisioni prese autonomamente dall’AI.

Normative chiare e specifiche possono aiutare a definire le responsabilità, ma è altresì importante che le aziende implementino rigorosi test pre-lancio e che sia garantito un monitoraggio continuo delle prestazioni dei sistemi AI.

Creare un feedback loop con gli utenti finali permette di raccogliere informazioni utili per migliorare la precisione e l’equità delle decisioni automatizzate, minimizzando così i potenziali danni.

IA spiegabile: costruire fiducia nel sistema

La IA spiegabile è fondamentale per costruire fiducia tra utenti e tecnologie AI.

Gli utenti devono comprendere come e perché un sistema di IA prende determinate decisioni.

Questo non solo aumenta la fiducia, ma è anche un requisito essenziale per conformarsi alle normative e garantire la sicurezza degli utenti.

Metodi di spiegabilità possono includere visualizzazioni dettagliate dei processi decisionali o fornire report chiari che delineano le ragioni delle decisioni.

Avere sistemi spiegabili è cruciale nelle applicazioni ad alto impatto come la sanità, la giustizia e la finanza, dove le decisioni errate possono avere conseguenze significative.

Le aziende devono quindi investire in ricerca e sviluppo per creare strumenti di spiegabilità robusti e integrabili che non compromettano la privacy o la sicurezza dei dati.

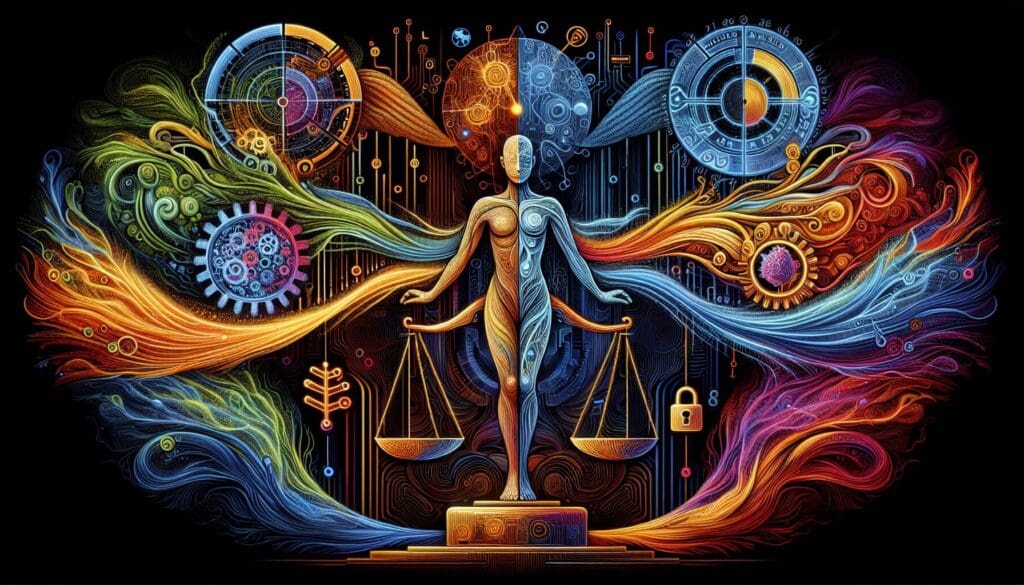

Considerazioni etiche nell’implementazione di AI

L’implementazione di AI solleva diverse considerazioni etiche.

È cruciale affrontare il potenziale abuso delle tecnologie AI per garantire che esse siano sviluppate e utilizzate in modo responsabile.

Le linee guida etiche devono considerare l’impatto sociale ed economico, includendo le implicazioni dell’automazione sul lavoro e le questioni di equità.

Partecipare a discussioni trasparenti con stakeholder vari e effettuare valutazioni di impatto etico prima e durante l’implementazione può aiutare a prevedere potenziali problemi.

Le organizzazioni devono adottare un approccio centrato sull’uomo, garantendo che la tecnologia serva prioritariamente il benessere delle persone e delle comunità, riducendo al minimo gli effetti deleteri.

Standard etici come guida nello sviluppo di IA

L’adozione di standard etici rappresenta una parte essenziale nel guidare il sviluppo di AI.

Questi standard devono essere chiari, comprensibili, e progettati per essere implementati a livello globale.

Organizzazioni internazionali, governi e industrie devono collaborare per creare un quadro comune che definisca aspettative e limiti chiari nello sviluppo delle tecnologie AI.

Le linee guida etiche devono anche essere adattabili ai rapidi cambiamenti tecnologici, consentendo un aggiornamento continuo che rispecchi le nuove scoperte.

Coinvolgere esperti di varie discipline, inclusi eticisti, tecnologi ed economisti, nel processo di creazione di questi standard garantisce un approccio bilanciato e inclusivo, assicurando che la tecnologia rispetti la dignità e i diritti umani.