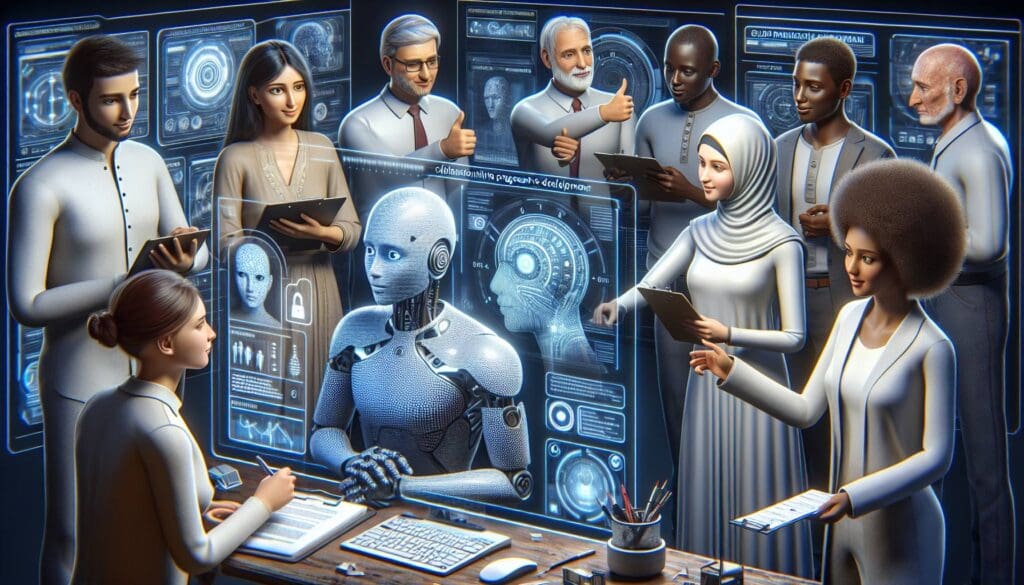

L’introduzione dell’Intelligenza Artificiale nel panorama lavorativo solleva questioni etiche fondamentali. Questo articolo esplora l’importanza di mantenere l’equità nel trattamento lavorativo, la necessità di trasparenza nelle decisioni automatizzate, la prevenzione dei bias umani nell’IA e la costruzione di un’etica condivisa nell’era digitale.

Mantenere l’equità nel trattamento lavorativo

Nell’era dell’Intelligenza Artificiale (IA), uno dei temi più urgenti da affrontare è l’equità nel trattamento lavorativo.

L’automazione e l’utilizzo di sistemi IA nelle risorse umane aprono nuove opportunità, ma comportano anche la responsabilità di garantire che le tecnologie non perpetuino o amplifichino le disuguaglianze esistenti.

Gli algoritmi, se non progettati e implementati con attenzione, possono infatti replicare i pregiudizi di chi li ha creati o dei dati su cui sono stati addestrati.

Pertanto, è essenziale che le aziende e i responsabili delle politiche adottino misure proattive per garantire che le tecnologie IA siano utilizzate in modi che promuovano l’inclusione e la diversità.

Questo significa non solo valutare regolarmente l’impatto delle decisioni algoritmiche, ma anche collaborare con esperti di etica, dati e legge per sviluppare sistemi che siano equi e trasparenti.

L’importanza di mantenere un dialogo aperto tra stakeholders e sviluppatori è cruciale per affrontare le potenziali minacce alla giustizia sociale e alla parità di opportunità nel luogo di lavoro.

L’importanza della trasparenza nelle decisioni automatizzate

La trasparenza è una componente essenziale nell’implementazione di sistemi di decisione automatizzati.

Quando le istituzioni adottano tecnologie basate sull’IA per processi decisionali come assunzioni, promozioni e valutazioni delle performance, la mancanza di trasparenza può portare a una mancanza di fiducia da parte dei dipendenti e del pubblico.

La trasparenza implica che le persone debbano avere accesso non solo ai risultati delle decisioni, ma anche ai processi e ai criteri utilizzati dagli algoritmi.

Ciò significa che le organizzazioni devono essere disposte a divulgare i dati di input, le logiche di decisione e le influenze degli algoritmi impiegati.

Inoltre, sviluppare e attuare politiche che includano revisioni periodiche e audit dei sistemi IA può contribuire a mantenere standard elevati di responsabilità.

Le aziende devono quindi investire nell’educazione e nella formazione del personale in modo che possano capire e comunicare chiaramente le decisioni dell’IA ai team e ai clienti, riducendo i timori di un sistema percepito come una ‘scatola nera’.

Questo approccio non solo promuove una cultura di apertura, ma facilita anche il miglioramento continuo dei sistemi IA grazie al feedback ricevuto.

L’IA potrebbe replicare bias umani: come evitarlo

I bias umani rappresentano uno dei rischi più significativi nell’adozione dell’Intelligenza Artificiale, poiché gli algoritmi sono spesso addestrati su data sets che riflettono pregiudizi e discriminazioni esistenti nella società.

Evitare che l’IA replichi o amplifichi questi bias è una sfida che richiede un approccio olistico e multidisciplinare.

In primo luogo, è essenziale essere consapevoli dei tipi di bias più comuni, come quelli di genere e razziali, che possono influenzare i dati raccolti e utilizzati per allenare gli algoritmi.

Le aziende devono implementare pratiche di data governance rigorose, assicurandosi che i dati siano rappresentativi e privi di pregiudizi.

Inoltre, l’inclusione di un team diversificato di sviluppatori e decision-makers può portare a risultati più equilibrati.

È importante anche adottare strumenti di monitoraggio dei bias, che analizzano e segnalano potenziali problemi nel comportamento degli algoritmi.

In ultima analisi, sviluppare un sistema di feedback che permette agli utenti di segnalare decisioni percepite come ingiuste contribuisce a migliorare continuamente i modelli IA.

Lavorare verso un’IA etica richiede sforzi costanti per promuovere la giustizia e l’equità nelle tecnologie in evoluzione.

Costruire un’etica condivisa nell’era dell’IA

Mentre la tecnologia continua a evolvere rapidamente, è imperativo che società, aziende e governi sviluppino e adottino un framework etico condiviso per l’uso dell’IA.

Costruire un’etica condivisa richiede il contributo di diverse discipline, includendo non solo informatici e ingegneri, ma anche filosofi, sociologi, economisti e giuristi.

Questo approccio assicura che le diverse prospettive siano rappresentate e che le soluzioni siano robuste e universalmente applicabili.

Uno dei passi fondamentali è l’istituzione di standard e linee guida globali che definiscano chiaramente cosa costituisce un uso etico dell’IA, tenendo conto delle differenze culturali e sociali.

Tali standard devono affrontare questioni di privacy, sicurezza dei dati, responsabilità e controllabilità dei sistemi.

Inoltre, implementare un sistema di valutazione etica che identifichi e mitighi i potenziali rischi associati all’IA è cruciale per evitare conseguenze negative non previste.

L’etica dell’IA dovrebbe anche essere integrata nei programmi educativi per preparare le future generazioni a gestire responsabilmente gli avanzamenti tecnologici.

In definitiva, l’obiettivo è promuovere un dialogo inclusivo e continuo, impegnando la comunità globale a considerare l’IA non solo come uno strumento potente, ma come una forza capace di guidare positivamente la società.