L’integrazione dell’intelligenza artificiale nel tessuto legale presenta nuove sfide e opportunità. Questo articolo esplora come il quadro normativo si sta adattando a queste innovazioni, affrontando questioni di responsabilità, protezione dei dati e controllo governativo.

Norme esistenti: adattamento alle nuove tecnologie

L’integrazione dell’intelligenza artificiale nel tessuto normativo del diritto è un fenomeno relativamente nuovo che richiede un veloce adattamento delle norme esistenti.

Molte delle norme legali attuali sono state elaborate in un contesto in cui le tecnologie digitali avanzate non erano ancora all’orizzonte, e come tali necessitano di revisione e adattamento.

Ad esempio, le leggi sulla privacy e sulla protezione dei dati sono state in gran parte strutturate in un periodo in cui il trattamento dei dati avveniva con tecnologie meno invasive e meno pervasive rispetto alle attuali.

Con l’avvento dell’IA, la capacità di analizzare e interpretare dati complessi ha sollevato nuove domande su come garantire che tali tecnologie siano utilizzate in modo etico e responsabile.

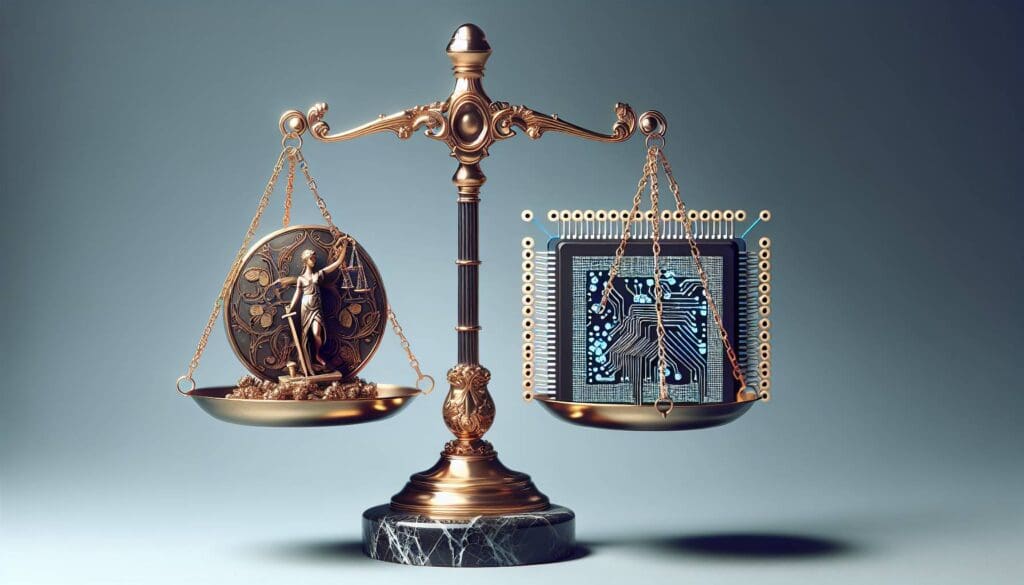

È fondamentale che le istituzioni legali trovino un equilibrio tra promuovere l’innovazione tecnologica e proteggere i diritti individuali, adattando le normative esistenti per renderle pertinenti a una nuova era tecnologica, senza tuttavia soffocare il progresso.

Questa sfida è accentuata dalla rapidità con cui l’IA evolve, spesso superando la capacità normativa di tenere il passo, rendendo urgente una revisione delle leggi che possa incorporare una certa flessibilità e anticipazione dei cambiamenti futuri.

Lacune normative: colmare i vuoti regolatori

Nel panorama dell’intelligenza artificiale emergono evidenti lacune normative che rappresentano un pericolo per la sicurezza e i diritti dei cittadini.

Questi vuoti regolatori nascono spesso dalla novità e complessità intrinseca delle tecnologie IA che sfuggono alle categorie tradizionali del diritto.

Ad esempio, l’uso di algoritmi nei sistemi giudiziari, finanziari o sanitari solleva domande fondamentali su trasparenza e bias che le leggi esistenti non sono attrezzate per affrontare.

Senza una chiara guida normativa, il rischio è quello di una frammentazione regolatoria, dove diverse giurisdizioni applicano approcci divergenti, portando a incertezza e aumentando i costi di conformità per le aziende.

La soluzione richiede uno sforzo concertato per sviluppare standard internazionali che possano fungere da base comune per normative nazionali, che siano chiari, prevedibili e flessibili.

Solo attraverso una cooperazione globale si può sperare di colmare queste lacune, assicurando che i benefici dell’IA possano essere goduti universalmente e che le sue potenziali minacce siano mantenute sotto controllo.

Responsabilità legale degli algoritmi decisionali

La questione della responsabilità legale degli algoritmi decisionali rappresenta una delle sfide più complesse nell’ambito del diritto moderno.

Gli algoritmi, specialmente quelli basati sull’apprendimento automatico, prendono decisioni che possono avere impatti significativi sulla vita delle persone, come negli ambiti della selezione del personale, dell’erogazione di credito o delle determinazioni giudiziarie.

Uno dei principali problemi è attribuire chiaramente la responsabilità quando tali sistemi producono risultati ingiusti o errati.

Attualmente, la responsabilità legale ricade spesso sugli sviluppatori o sugli enti che implementano l’algoritmo, ma questa struttura potrebbe non essere equa, dato che gli sviluppatori potrebbero non avere controllo sull’uso finale del loro prodotto.

Inoltre, la natura ‘black box’ di molti algoritmi rende difficile una comprensione chiara dei criteri decisionali.

È cruciale stabilire quadri normativi che delineino chi detiene la responsabilità nei vari scenari e come viene determinata e verificata la correttezza dei processi decisionali automatizzati.

Potrebbe essere necessario un nuovo paradigma legale che incorpori non solo chiari protocolli di sviluppo e implementazione, ma anche meccanismi robusti di audit e revisione continua per garantire affidabilità e trasparenza.

Consenso informato e protezione dei dati

Con l’intelligenza artificiale, il consenso informato e la protezione dei dati diventano temi di primo piano in materia di diritto.

L’IA è intrinsecamente legata alla raccolta e all’elaborazione di grandi quantità di dati, sollevando preoccupazioni sulla privacy e sull’autonomia individuale.

Il consenso informato implica che gli utenti comprendano chiaramente come i loro dati saranno utilizzati e abbiano la possibilità di accettare o rifiutare questo uso.

Tuttavia, data la complessità degli algoritmi moderni e la difficoltà per l’utente medio di comprenderne appieno le implicazioni, garantire un vero consenso informato è una sfida.

Inoltre, molte giurisdizioni adottano approcci diversi sulla protezione dei dati, il che può complicare la conformità per le imprese che operano a livello internazionale.

Regolamentazioni come il GDPR nell’Unione Europea rappresentano un tentativo di affrontare queste sfide, stabilendo norme chiare su come ottenere il consenso e proteggere i dati personali.

È cruciale che queste normative continuino ad evolversi per affrontare le nuove tecnologie IA, bilanciando la necessità di innovazione con i diritti di privacy degli individui.

Controllo sull’IA: un dibattito aperto

Il controllo sull’intelligenza artificiale è al centro di un importante dibattito che coinvolge accademici, legislatori e aziende tecnologiche.

Il tema principale è come regolamentare efficacemente una tecnologia in rapida evoluzione senza ostacolare l’innovazione né amplificare potenziali rischi.

Alcuni sostengono la necessità di una regolamentazione rigida per prevenire abusi e garantire sicurezza, mentre altri difendono un approccio più flessibile che favorisca lo sviluppo tecnologico.

Esistono anche preoccupazioni sul potere e l’autonomia crescenti dei sistemi di IA, che possono sfuggire al controllo dei loro creatori e prendere decisioni con conseguenze impreviste.

L’obiettivo di trovare un equilibrio tra controllo e libertà di innovazione richiede dialogo e cooperazione tra tutte le parti coinvolte, per definire regole che siano allo stesso tempo efficaci e non eccessivamente restrittive.

Strumenti come i comitati etici indipendenti e le valutazioni di impatto potrebbero aiutare a monitorare e guidare lo sviluppo sicuro dell’IA, garantendo che queste tecnologie lavorino a beneficio della società.

Il ruolo dei governi nell’innovazione responsabile

I governi hanno un ruolo cruciale nell’assicurare che l’innovazione tecnologica sia guidata da principi di responsabilità e sostenibilità.

Essi sono chiamati a definire normative chiare e lungimiranti che incoraggino l’innovazione, garantendo al contempo la protezione dei cittadini.

Questo delicato bilanciamento richiede l’adozione di processi normativi che siano adattabili e basati sull’evidenza, pronti a rispondere rapidamente ai cambiamenti tecnologici in corso.

Inoltre, i governi possono promuovere un’innovazione responsabile attraverso la creazione di incentivi per le imprese che sviluppano tecnologie etiche e sostenibili.

Promuovendo l’educazione e la consapevolezza pubblica sui temi dell’IA, i governi possono anche contribuire a preparare la società a un futuro in cui queste tecnologie giocheranno un ruolo sempre più centrale.

Infine, la collaborazione internazionale è essenziale per affrontare le sfide globali poste dall’intelligenza artificiale, e i governi devono giocare un ruolo attivo nel promuovere dialoghi e accordi internazionali che possano guidare un utilizzo condiviso, sicuro e vantaggioso dell’IA su scala globale.